本专题汇集了与Mamba相关的各类工具和资源,通过分类整理和详细介绍,帮助用户快速找到适合自己需求的工具,提高工作和学习效率。

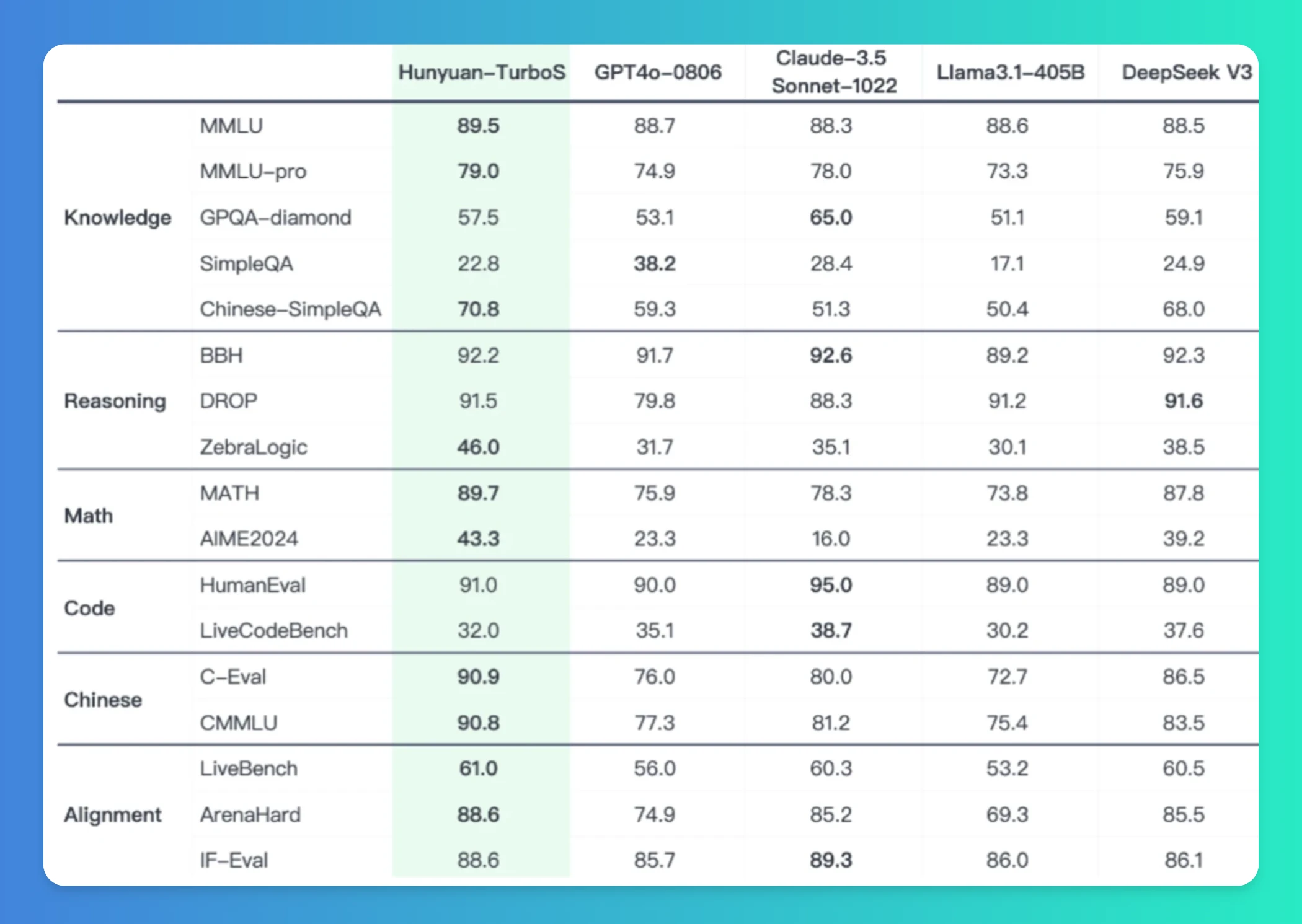

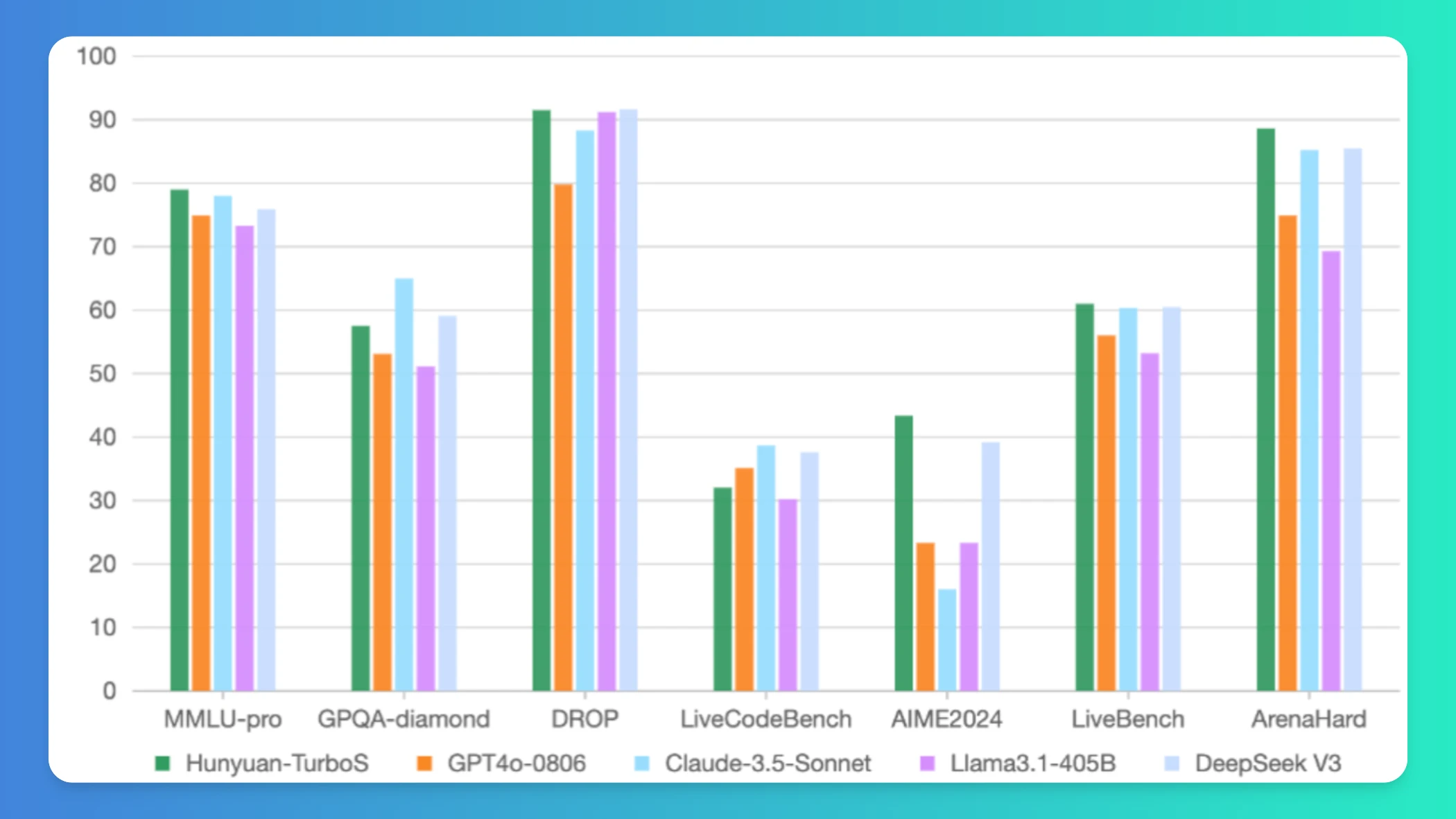

专业测评与排行榜

工具功能对比

以下是对各工具的功能、适用场景、优缺点的详细分析:

腾讯混元Turbo S

- 功能:高效推理模型,支持多领域推理、内容创作及多模态生成。采用Hybrid-Mamba-Transformer架构,提升推理效率并降低计算成本。

- 适用场景:对话系统、代码生成、逻辑推理等需要快速响应和多模态处理的场景。

- 优点:性能优越,推理速度快,支持多种任务类型。

- 缺点:对硬件要求较高,可能不适合资源受限环境。

T1(Thinker)

- 功能:深度思考模型,支持逻辑推理与联网搜索,具备高速响应和长文本处理能力。采用Hybrid-Mamba-Transformer架构。

- 适用场景:教育、医疗、市场分析等需要复杂指令处理和多任务场景。

- 优点:输出简洁、幻觉低,适合复杂任务处理。

- 缺点:训练成本较高,可能不适用于轻量级应用。

Granite 4.0 Tiny Preview

- 功能:轻量级语言模型,支持在消费级GPU上运行多个长上下文任务。采用混合Mamba-2/Transformer架构,支持无位置编码(NoPE)处理128K tokens上下文。

- 适用场景:边缘设备部署、长文本分析及企业级应用开发,适合资源受限环境。

- 优点:内存需求低,推理时仅激活1B参数,适合边缘设备。

- 缺点:性能可能不及大型模型,在复杂任务中表现有限。

ACTalker

- 功能:基于视频扩散模型的端到端工具,可生成高质量、自然的说话人头部视频。支持多信号控制(如音频、表情)。

- 适用场景:虚拟主播、远程会议、在线教育等需要高质量视频生成的场景。

- 优点:视频质量高,同步性好,适用于多种视频生成任务。

- 缺点:对硬件和数据处理能力要求较高。

Bamba-9B

- 功能:解码型语言模型,专注于提升大型语言模型的推理效率,擅长处理长文本。采用恒定KV-cache设计解决内存带宽瓶颈问题。

- 适用场景:机器翻译、智能客服、内容推荐、自动摘要等需要高效推理的任务。

- 优点:吞吐量高,延迟低,支持模型量化及长上下文扩展。

- 缺点:可能在极复杂任务中表现不如其他模型。

LongLLaVA

- 功能:多模态大型语言模型,结合Mamba和Transformer模块,利用2D池化技术压缩图像token,大幅提升处理大规模图像数据的效率。

- 适用场景:视频理解、高分辨率图像分析及多模态代理任务,广泛应用于医学影像诊断等领域。

- 优点:处理多模态数据能力强,尤其擅长检索、计数和排序任务。

- 缺点:训练和部署复杂度较高。

Jamba

- 功能:生产级别大语言模型,结合结构化状态空间模型(SSM)和传统Transformer架构,具备高吞吐量和低内存占用的特点。

- 适用场景:研究领域,未来可用于安全版本的应用开发。

- 优点:开源许可灵活,支持长文本序列处理。

- 缺点:目前主要面向研究领域,实际应用尚需进一步优化。

腾讯快思考模型(混元hunyuan-TurboS)

- 功能:响应速度较前代产品提升一倍,首字时延降低44%,适用于知识、数理和创作等多方面应用。

- 适用场景:即时生成内容、知识问答、创作辅助等需要快速响应的任务。

- 优点:生成流畅,响应迅速,适合多领域应用。

- 缺点:可能在复杂任务中表现不如深度思考模型。

排行榜

根据综合性能、适用场景及优缺点分析,以下是排名(从高到低): 1. 腾讯混元Turbo S - 综合性能最优,适用于多模态任务。

2. T1(Thinker) - 深度思考能力突出,适合复杂任务。

3. Bamba-9B - 高效推理,适合长文本处理。

4. LongLLaVA - 多模态处理能力强,适合图像和视频任务。

5. Granite 4.0 Tiny Preview - 轻量级优势明显,适合资源受限环境。

6. ACTalker - 视频生成质量高,适合多媒体应用。

7. Jamba - 研究领域潜力大,但实际应用尚需完善。

8. 腾讯快思考模型(混元hunyuan-TurboS) - 快速响应能力强,适合即时生成任务。使用建议

- 即时生成内容:选择腾讯快思考模型或混元Turbo S。

- 复杂任务处理:优先考虑T1(Thinker)或LongLLaVA。

- 资源受限环境:使用Granite 4.0 Tiny Preview。

- 视频生成任务:选择ACTalker。

- 长文本处理:推荐Bamba-9B。

- 多模态任务:选择LongLLaVA。

研究领域:尝试Jamba。

优化标题 Mamba专题:前沿AI工具与资源精选

优化描述 本专题汇集了基于Mamba架构及其衍生技术的最新AI工具与资源,涵盖语言模型、多模态处理、视频生成等多个领域。无论是即时生成内容、复杂任务推理还是资源受限环境下的应用开发,这里都能为您提供最适合的解决方案。

优化简介 Mamba专题致力于为用户提供全面的AI工具与资源信息,帮助您更好地了解和运用Mamba相关技术。专题内容包括腾讯混元系列模型、IBM推出的轻量级语言模型Granite 4.0 Tiny Preview、视频生成工具ACTalker以及多模态处理模型LongLLaVA等。这些工具不仅在性能、效率和适用场景上各有千秋,还覆盖了从对话系统、内容生成到图像处理的广泛领域。通过本专题,您可以快速找到适合自己需求的工具,从而提高工作和学习效率。无论您是开发者、研究人员还是普通用户,Mamba专题都将为您提供专业的指导和支持。

腾讯混元Turbo S是腾讯推出的高效AI模型,采用Hybrid-Mamba-Transformer架构,提升推理效率并降低计算成本。支持快速响应、多领域推理、内容创作及多模态生成,适用于对话、代码、逻辑推理等场景。兼具短思维链与长思维链能力,性能对标行业领先模型。

Granite 4.0 Tiny Preview是IBM推出的轻量级语言模型,具备高效计算能力和紧凑结构,支持在消费级GPU上运行多个长上下文任务。采用混合Mamba-2/Transformer架构,结合高效与精准优势,支持无位置编码(NoPE)处理128K tokens上下文。内存需求降低72%,推理时仅激活1B参数,适用于边缘设备部署、长文本分析及企业级应用开发,适合资源受限环境下的AI研究与

发表评论 取消回复